2025년 5월 20일 (현지시간) 구글은 연례 개발자 컨퍼런스 '구글 I/O 2025'를 통해 'AI가 곧 생활'이라는 선언을 했다. 이 행사는 인공지능 기술의 진정한 일상화를 위한 깊이 있는 기술적 혁신을 공개했다.

특히, 온-디바이스 AI(On-Device AI)의 성능 극대화와 멀티모달 에이전트(Multimodal Agents)의 발전이 이번 행사의 핵심이었고, 이는 AI가 클라우드를 넘어 사용자 기기에서 더욱 지능적이고 자율적으로 작동하는 미래를 예고한다. 이러한 혁신 뒤에는 구글의 자체 개발 AI 칩인 TPU(Tensor Processing Unit)의 역할이 크게 작용하며, 원조 '트랜스포머 모델'의 저력을 입증했다.

제미나이 2.5: '딥 싱크' 아키텍처와 효율성을 통한 추론 능력 강화

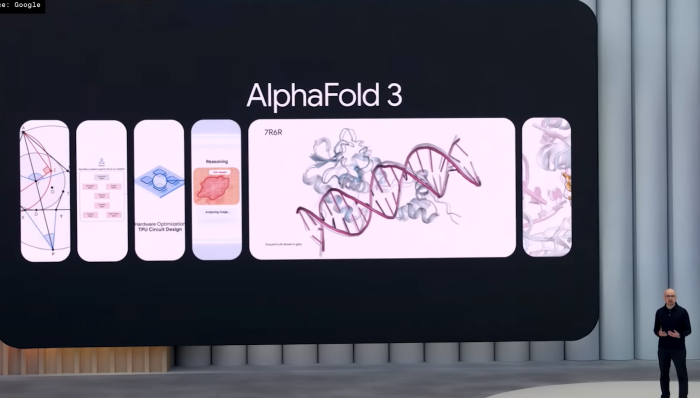

이번 I/O의 기술적 백미는 단연 제미나이 2.5(Gemini 2.5) 모델의 발전이다. 구글은 제미나이 2.5 프로(Gemini 2.5 Pro)에 ‘딥 싱크(Deep Think)'라는 혁신적인 추론 아키텍처를 도입한다. 이 모드는 AI가 복잡한 문제를 해결할 때 다단계 병렬 추론(Multi-step Parallel Reasoning) 과정을 수행하고, 그 과정을 사용자에게 상세히 설명하도록 설계된다.

이는 특히 수학적 증명, 과학적 가설 검증, 복잡한 코드 디버깅과 같은 고난도 작업에서 AI의 문제 해결 능력을 획기적으로 향상시킨다. 구글은 이 기술이 기존 벤치마크에서 경쟁 모델 대비 압도적인 성능을 보였다고 강조하며, AI의 '사고' 능력을 한 단계 끌어올렸음을 입증한다.

이러한 제미나이 2.5 프로의 뛰어난 연산 능력과 복잡한 추론 처리는 구글 클라우드에 배치된 TPU 인프라가 뒷받침한다. 특히 '딥 싱크'와 같은 고도화된 AI 모델의 학습 및 추론에는 TPU의 대규모 병렬 처리 능력이 필수적이다.

이는 2017년 구글이 발표한 '트랜스포머 모델'이 보여준 어텐션 메커니즘(Attention Mechanism)의 강력한 확장성과 효율성을 제미나이 2.5에서 더욱 발전시킨 결과이다. 원조 트랜스포머 모델의 핵심 아이디어가 복잡한 멀티모달 데이터 처리와 심층 추론에까지 효과적으로 적용되고 있음을 증명한다.

또한, 효율성에 초점을 맞춘 제미나이 2.5 플래시(Gemini 2.5 Flash)는 단순히 크기가 작은 모델이 아니다. 이 모델은 멀티모달 입력 처리 능력을 유지하면서도 긴 컨텍스트 윈도우(Long Context Window)를 지원하고, 토큰 사용량을 최대 30% 절감하는 기술적 진보를 이룬다.

이는 모바일 기기나 엣지 디바이스와 같은 제약된 환경에서 실시간 멀티모달 AI 애플리케이션을 구동할 핵심 동력이 된다. 플래시 모델의 오디오 생성 데모는 그 속도와 자연스러움으로 참석자들의 이목을 사로잡았는데, 이는 경량화된 트랜스포머 아키텍처(Lightweight Transformer Architecture)와 효율적인 인코딩/디코딩 메커니즘의 결과이다.

보안 측면에서도 기술적 강화가 있었다. 제미나이 2.5는 간접 프롬프트 주입(Indirect Prompt Injection)과 같은 새로운 유형의 공격에 대한 방어 메커니즘을 강화하여 사용자 데이터의 안전성을 높인다.

더불어, 개발자가 AI 모델의 동작을 더 깊이 이해하고 디버깅할 수 있도록 '사고 요약(Thought Summaries)' 기능을 도입하는데, 이는 모델이 특정 응답을 도출하기까지의 내부 추론 단계와 중간 생각을 시각적으로 또는 텍스트로 요약하여 보여주는 기술이다. 이는 모델의 해석 가능성(Model Interpretability)을 높이는 중요한 진전으로 평가된다.

'프로젝트 아스트라': 온-디바이스 멀티모달리티와 실시간 에이전트 아키텍처

구글은 '프로젝트 아스트라(Project Astra)'를 통해 AI가 클라우드 의존도를 줄이고 사용자 기기에서 직접 구동되는 온-디바이스 멀티모달 에이전트의 가능성을 보여주었다. '제미나이 라이브(Gemini Live)'는 이 아스트라 프로젝트의 핵심 구성 요소로, 스마트폰이나 웨어러블 기기의 카메라 및 화면 공유 기능과 직접 연동된다.

이 기술은 실시간 비디오 스트림 분석(Real-time Video Stream Analysis), 오디오 입력의 즉각적인 음성-텍스트 변환(Speech-to-Text Transcriptions), 그리고 온-디바이스에서 작동하는 소형 언어 모델(Small Language Models, SLMs)을 결합하여 지연 시간을 최소화한다.

특히, AI가 사용자의 주변 환경을 실시간으로 인지하고, 사용자의 음성 명령과 시각적 맥락을 동시에 이해하여 능동적으로 정보를 제공하거나 작업을 수행하는 능력은 동시적인 멀티모달 입력 처리(Concurrent Multimodal Input Processing)와 예측적 에이전트 행동 트리(Predictive Agent Behavior Trees)의 결과물이다.

이는 면접 준비 시 AI가 사용자의 자세나 발화를 분석하고 즉각적인 피드백을 제공하거나, 마라톤 훈련 중 사용자의 경로와 심박수를 인지하여 맞춤형 조언을 제공하는 등 실제 생활에 밀접하게 통합되는 AI 비서의 가능성을 제시한다. 사용자의 평소 대화 스타일, 어조, 선호하는 단어 선택까지 학습하여 자연스러운 답장을 생성하는 기능은 사용자 행동 패턴 학습(User Behavior Pattern Learning) 및 개인화된 언어 모델 미세 조정(Personalized Language Model Fine-tuning) 기술이 적용된 결과이다.

생성형 AI의 발전: Veo 3, Flow, 이마젠 4의 미디어 혁신

미디어 콘텐츠 생성 분야에서는 AI 모델의 생성 품질과 제어 가능성이 크게 향상되었다.

Veo 3는 텍스트, 이미지, 또는 기존 비디오 프롬프트를 입력받아 고해상도(예: 1080p) 비디오를 생성할 뿐만 아니라, 해당 비디오에 맞는 사실적인 사운드트랙(대화, 환경 소리 포함)까지 자동으로 생성하는 멀티모달 비디오 생성 모델이다.

이는 확산 모델(Diffusion Models)과 생성적 적대 신경망(Generative Adversarial Networks, GANs)의 최신 발전과 오디오 생성 모델(Audio Generation Models)의 통합을 통해 가능했다. 특히, 긴 시퀀스 비디오 생성 시 발생하는 일관성 문제 해결을 위한 시간적 일관성 메커니즘(Temporal Consistency Mechanisms)이 강화된다.

Flow는 생성형 영상 기획 툴로, 텍스트나 이미지를 통해 짧은 비디오 클립을 생성하고, 이를 '장면 빌더(Scene Builder)'라는 직관적인 인터페이스에서 조합하여 전체 영상을 구성한다. 이는 모듈형 비디오 생성 아키텍처(Modular Video Generation Architecture)를 기반으로 하며, 사용자 의도에 따라 클립 간의 전환 효과와 스토리텔링 흐름을 제어할 수 있는 지능형 시퀀싱 알고리즘(Intelligent Sequencing Algorithms)을 포함한다.

이마젠 4(Imagen 4)는 구글의 차세대 이미지 생성 모델이다. 머리카락, 털, 옷감과 같은 미세한 질감을 표현하는 능력이 대폭 향상된다. 이는 더욱 정교한 잠재 공간 학습(Finer-grained Latent Space Learning)과 텍스트-이미지 정렬(Text-to-Image Alignment) 기술의 발전 덕분이다.

또한, 이미지 내에 정확하고 자연스러운 텍스트를 삽입하는 기능은 오클루전 인식 텍스트 렌더링(Occlusion-Aware Text Rendering)과 텍스트-이미지 시맨틱 일관성(Text-Image Semantic Consistency) 기술의 결과물이다.

AI 통합 검색, 워크스페이스, 안드로이드 개발자 도구의 기술적 심화 및 협력 관계

구글 검색의 'AI 모드'는 제미나이 2.5를 기반으로 하며, 사용자의 질의에 대해 단순한 키워드 매칭을 넘어 다단계 추론(Multi-step Reasoning)을 수행한다. 이는 복잡한 질문에 대해 여러 정보 소스를 통합하고, 추론 과정을 거쳐 종합적인 답변을 제공하는 능력이다.

또한, 비디오 검색 기능은 비디오 콘텐츠 내부의 특정 시점이나 객체를 인식하여 정보를 추출하는 비디오 이해 모델(Video Understanding Models)을 활용한다. 쇼핑 분야의 가상 피팅(Virtual Fitting) 기술은 인체 포즈 추정(Human Pose Estimation), 3D 의류 시뮬레이션(3D Garment Simulation), 그리고 사실적인 렌더링(Realistic Rendering) 기술이 결합되어 사용자 전신 사진 한 장으로 다양한 의류를 착용해 볼 수 있도록 구현된다.

구글 워크스페이스의 AI 기능은 맥락 이해 기반의 자동화(Context-Aware Automation)에 중점을 둔다. Gmail의 "Help Me Organize and Track" 기능은 첨부 파일의 내용을 분석하고(예: 문서 분류 및 정보 추출 모델), 그에 기반하여 데이터를 자동으로 분류하고 Google Sheets에 입력하는 작업을 수행한다. 이는 온라인 학습(Online Learning)과 작업 자동화 에이전트(Task Automation Agents)의 결합으로 가능하다.

안드로이드 생태계의 AI 통합은 온-디바이스 AI 추론 최적화와 실시간 상호작용에 초점을 맞춘다. 특히 안드로이드 XR 스마트 안경에 구현된 실시간 언어 번역 기능은 소형의 신경망 기계 번역(Neural Machine Translation, NMT) 모델을 온-디바이스에서 구동하며, 음성 인식(ASR)과 음성 합성(TTS) 기술을 결합하여 지연 시간을 최소화한다.

이러한 온-디바이스 AI 성능 향상에는 퀄컴(Qualcomm)과의 긴밀한 협력이 중요한 역할을 한다. 퀄컴의 스냅드래곤 프로세서에 탑재된 전용 AI 엔진(NPU)은 구글의 제미나이 나노(Gemini Nano)와 같은 온-디바이스 모델의 효율적인 구동을 가능하게 하고, 이를 통해 삼성전자의 갤럭시 스마트폰 등 안드로이드 플래그십 기기에서 더욱 빠르고 개인화된 AI 경험을 제공한다.

개발자 도구의 경우, '스티치(Stitch)'는 자연어 프롬프트나 이미지 스케치를 기반으로 웹/모바일 앱의 UI 컴포넌트와 해당 코드를 생성하는 코드 생성 모델(Code Generation Models)과 UI/UX 디자인 패턴 학습(UI/UX Design Learning) 기술을 활용한다.

비동기 코드 에이전트 '줄스(Jules)'는 깃허브(GitHub)와 같은 버전 관리 시스템에 통합되어 코드 스멜 감지(Code Smell Detection), 자동 리팩토링(Automated Refactoring), 단위 테스트 생성(Unit Test Generation), 그리고 CI/CD 파이프라인 연동(CI/CD Pipeline Integration)을 통해 개발 워크플로우를 자동화한다.

안드로이드 스튜디오 내 제미나이 통합은 코드 완성(Code Completion), 코드 디버깅(Code Debugging), 성능 프로파일링(Performance Profiling), 그리고 프로젝트별 테스트 스위트 생성(Project-specific Test Suite Generation)과 같은 고급 기능을 제공한다.

구글 I/O 2025는 AI가 단순히 하나의 기술 영역이 아니라, 모든 제품과 서비스의 근간을 이루는 AI 우선주의(AI-first) 전략을 더욱 공고히 한다. 온-디바이스 AI의 발전과 멀티모달 에이전트의 등장은 AI가 인간의 일상에 더욱 깊이 통합되고, 보다 지능적이고 자율적인 방식으로 삶을 변화시킬 것임을 보여주는 중요한 이정표가 된다.

특히 삼성전자와 퀄컴 등과의 전략적 협력을 통해 구글의 AI 기술이 더욱 광범위한 기기와 서비스에 적용될 수 있는 토대가 마련된다는 점은 주목할 만하다.

IT News 김한비 기자 itnews@

![[보고서] 딥씨크 출현과 한국 AI 미래전략](http://itnews.live/wp-content/uploads/2025/02/7-218x150.png)

![[2024 애플 동향] ③ 애플카 ‘프로젝트 타이탄’의 실패 원인](http://itnews.live/wp-content/uploads/2024/03/1-2-218x150.png)

![[2024 애플 동향] ② 애플카 ‘프로젝트 타이탄’ 10년간 의 여정](http://itnews.live/wp-content/uploads/2024/03/4-218x150.png)

![[2024 애플 동향] ① 애플 프로젝트 타이탄’ 종료](http://itnews.live/wp-content/uploads/2024/03/Midjourney-218x150.png)

![[구글 I/O 2025] ‘안드로이드 XR’이 제시하는 몰입형 컴퓨팅의 미래](http://itnews.live/wp-content/uploads/2025/05/구글-IO-2025-4-218x150.png)